Description

Architectures et Infrastructures Big Data

Durée : 28 heures

Modalités techniques d’évaluation : Évaluation des connaissances par QCM, évaluation des compétences au travers de travaux pratiques et de cas d’études. Contrôle de l’acquisition des connaissances et des compétences pendant la formation par le formateur.

Moyens pédagogiques : Apports théoriques réalisés en classe et complétés par de nombreux travaux pratiques permettent aux participants de disposer d’une expérience concrète. A l’issue des sessions magistrales, réalisation de cas d’études tutorés.

Objectifs :

- Exploiter les architectures Big Data

- Mettre en place des socles techniques complets pour des projets Big Data.

- Comprendre l’architecture et l’infrastructure sous-jacentes d’un projet Big Data

- Déterminer la nature des données manipulées

- Gérer les données de manière qualitative afin de réaliser des analyses pertinentes et rigoureuses

- Connaître les architectures distribuées dominantes du marché

- Mettre en œuvre un cluster Hadoop

- Mettre en œuvre un traitement MapReduce avec Spark

Programme :

Définition et contexte spécifique des projets Big Data

- Les origines du Big Data

- Les données au cœur des enjeux

– Explosion du nombre de données

– Liens entre Big Data et IoT (internet des objets)

– Données structurées, semi-structurées, non structurées - Les limites des architectures actuelles

- Définition d’un système Big Data

- Principes de fonctionnement

- Les différentes offres des marchés

Propriété de la donnée, environnement juridique du traitement, sécurité

- Sécurité éthique et enjeux juridiques

- Les données personnelles

- Les informations sensibles, interdites de collecte

- La CNIL régule les données numériques

- Les accords intra-pays

Impact des choix technologiques en matière d’infrastructure et d’architecture Big Data

- Les architectures décisionnelles « traditionnelles » (datastore, datawarehouse, datamart…)

- Philosophie des bases NoSQL : column family, orienté document, clé-valeur, graphe

- Quelques acteurs (MongoDB, Cassandra…)

- Big Table/ Big Query

- Les database machine (Exadata)

- Les bases de données vectorielles (Sybase IQ)

- Hadoop un système totalement autonome ?

- Conséquences techniques et financières selon les architectures

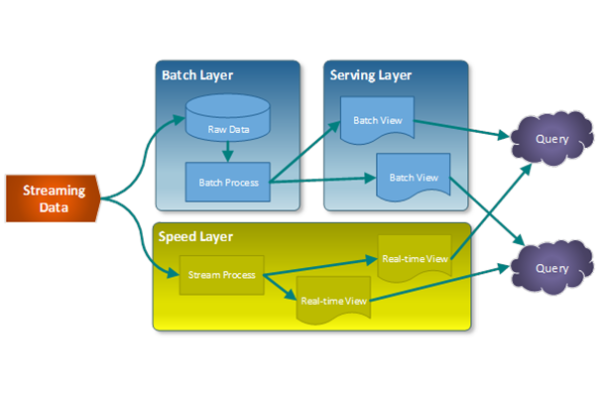

Architectures distribuées

- Problématiques et enjeux d’une architecture distribuée

- Des données cohérentes, disponibles et tolérantes aux pannes ?

- Les architectures massivement parallèles

- L’ouverture aux traitements complexes (datamining, machine learning, etc.)

- Paradigmes de calculs distribués

- Les bases NoSQL et le calcul distribué (exemple avec MongoDB)

Qualité des données (dataquality)

- Liens entre infrastructure et qualité des données (exemples de problèmes)

- Pas de qualité pas d’analyse

- Les 4 V

- Base à chaud, base à froid

- Les apports d’un outil de Dataquality

- Pourquoi utiliser un ETL ?

- Illustration via Talend Data Integration

- Analyser les données en les fusionnant avec les données internes

- Le Master Data Management (MDM) : phase indispensable de la réconciliation des données Big Data avec les données décisionnelles ?

Préparation et configuration du cluster Hadoop

- Principes de fonctionnement de Hadoop Distributed File System (HDFS)

- Principes de fonctionnement de MapReduce

- Design « type » du cluster

- Critères de choix du matériel

Installation d’une plateforme Hadoop

- Type de déploiement

- Installation d’Hadoop

- Installation d’autres composants (Hive, Pig, HBase, Flume…)

- Quelques différences entre les distributions Cloudera, Hortonworks et MapR

Gestion d’un cluster Hadoop

- Gestion des nœuds du cluster Hadoop

- Les TaskTracker, JobTracker pour MapReduce

- Gestion des tâches via les schedulers

- Gestion des logs

- Utiliser un manager

Gestion des données dans HDFS

- Import de données externes (fichiers, bases de données relationnelles) vers HDFS

- Manipulation des fichiers HDFS

Configuration avancée

- Gestion des autorisations et de la sécurité

- Reprise sur échec d’un name node (MRV1)

- NameNode high availability (MRV2/YARN)

Monitoring et optimisation Tuning

- Monitoring (Ambari, Ganglia…)

- Benchmarking/profiling d’un cluster

- Les outils Apache GridMix, Vaaidya

- Choisir la taille des blocs

- Autres options de tuning (utilisation de la compression, configuration mémoire…)

Architecture Hadoop avec Spark

- La philosophie de Spark par rapport à Hadoop

- Les différentes associations Hadoop/Spark

- Comparaison des performances

- Différences concernant la reprise après incident

MapReduce Spark

- Maîtriser le fonctionnement de MapReduce Spark

- Configuration d’un nœud Hadoop pour le calcul MapReduce Spark

- Introduction à Hadoop Streaming pour le prototypage rapide de MapReduce Spark

- Écriture de MapReduce Spark pour la résolution de problèmes concrets