L’automatisation des tests d’un développement logiciel, est un investissement lourd mais rentable. Découvrez les aspects organisationnels/financiers, les bonnes pratiques et les outils de l’automatisation des différents types de test : tests unitaires, tests d’intégration, tests fonctionnels, tests de performance.

Description

Durée : 28 heures

Modalités techniques d’évaluation : Évaluation des connaissances par QCM, évaluation des compétences au travers de travaux pratiques et de cas d’études. Contrôle de l’acquisition des connaissances et des compétences pendant la formation par le formateur.

Moyens pédagogiques : Apports théoriques réalisés en classe et complétés par de nombreux travaux pratiques permettent aux participants de disposer d’une expérience concrète. A l’issue des sessions magistrales, réalisation de cas d’études tutorés.

Objectifs pédagogiques

À l’issue de la formation, le participant sera en mesure de :

- Utiliser un référentiel de tests et paramétrer des liens vers des outils connexes, pour automatiser une campagne de test

- Faire une analyse statique de code et de couverture de tests et l’intégrer dans une chaîne de fabrication logicielle

- Utiliser les techniques d’objets factices, souches ou simulacres et mettre en place un serveur d’intégration continue

- Mettre en œuvre une automatisation de tests fonctionnels sur client lourd et sur Web

- Automatiser les tests de performance, avec mise en place d’un test de détermination du seuil de déni de service

Actions collectives

Travaux pratiques

Introduction, rappels sur le processus du test logiciel

- Rôle du test dans le processus de développement.

- Les tests : unitaires, fonctionnels, etc.

- Les différentes méthodes de test.

- Processus de test et stratégie de test.

- Outils et méthodes intervenant à différentes étapes.

Travaux pratiques

Installation de quelques outils.

Automatisation de la gestion des tests

- Gestion de la couverture des exigences par les tests. Notion de couverture et de granularité.

- Démarche de mise au point : organisation des suites de tests et création des cas.

- Faut-il automatiser un test ? Critères à prendre en compte ?

- Préparation à l’automatisation.

- Construction de la population de test.

- Mise au point et vérification des tests (Revue)

- Exécution, enregistrement des anomalies. Notion de rapport d’incident d’après l’IEEE.

- Gestionnaires d’anomalies. Automatisation de la création des anomalies.

- Analyse de résultats d’exécution de tests. Consolidation des tests.

Travaux pratiques

Utilisation d’un référentiel de tests. Paramétrages de ponts vers des outils connexes (TestLink/Squash/Quality Center ou autres…).

Automatisation des tests unitaires

- Organisation et bonnes pratiques pour les tests unitaires.

- Critères d’automatisation.

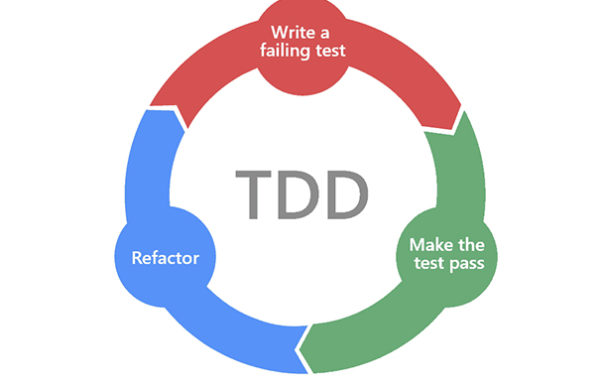

- Tests unitaires : Tests Driven Development.

- Mesure de la couverture de code : couverture des tests structurels, couverture d’instructions et branches.

- Analyse statique de code : analyse outillée du code source hors exécution (règles de codage) : Checkstyle, Cobertura.

- Automatisation avec un fichier de configuration.

- Analyse dynamique de code : couverture des instructions, des branches, des prédicats…

- Automatisation avec un outil d’analyse de couverture.

- Organisation des tests unitaires, pair programming, pair testing.

- Utilisation des frameworks : gestion des scripts de tests, gestion des données de tests, récupération des résultats.

Travaux pratiques

Mise en œuvre de tests unitaires avec Junit/TestNG. Intégration dans une chaîne de fabrication de logiciel (Ant/Maven…).

Automatisation des tests d’intégration

- Stratégies propres à l’intégration : big-bang, « au fil de l’eau », par incréments etc.

- Intégration ascendante versus descendante. Intégrations mixtes.

- Objets simulacres : bouchons pour simuler les fonctions appelées, mocking pour remplacer un objet. Les frameworks.

- Intégration continue : mise en place de gestionnaire de configuration, constructeur de build, outils de pilotage.

- Focus sur un gestionnaire de configuration logiciel.

- Signalement automatique des anomalies.

- Exécution automatique et cyclique des tests logiciels.

- Focus sur un constructeur de build.

- Focus sur un serveur d’intégration continue.

Travaux pratiques

Utilisation d’objets simulacres. Mise en place d’un serveur d’intégration continue (Jenkins, Hudson ou Continuum).

Automatisation du test fonctionnel

- Définition du test fonctionnel, non-régression.

- Le test simulant l’action des utilisateurs à partir des interfaces utilisateurs (IHM).

- Constats sur l’automatisation du test fonctionnel.

- Automatisation des tests via l’IHM, via des interfaces de programmation (API).

- Chaîne d’outils, robots de test, script (API publiques).

- Gestion de l’obsolescence des tests.

Travaux pratiques

Automatisation de tests fonctionnels sur client lourd et sur Web. Utilisation de robots, d’une couche logicielle publique (API). Mise en oeuvre d’un outil d’automatisation (Katalon Studio avec Selenium/HP QuickTest Pro).

Automatisation des tests système

- Les différents type de tests système : performance, charge, stress.

- Constats sur les tests de performance.

- Tests de performance, définition des indicateurs.

- Scripts de tests de performance. Mise en œuvre d’outils et analyse.

- Tests de montée en charge, tests de stress : présentation des indicateurs clés et de l’outillage.

- Gérer la base de données de tests. Gestion du contexte.

Travaux pratiques

Mise en place d’un test de charge.